من المهم جدًا ترك الأمر لـ Microsoft و Google و Meta

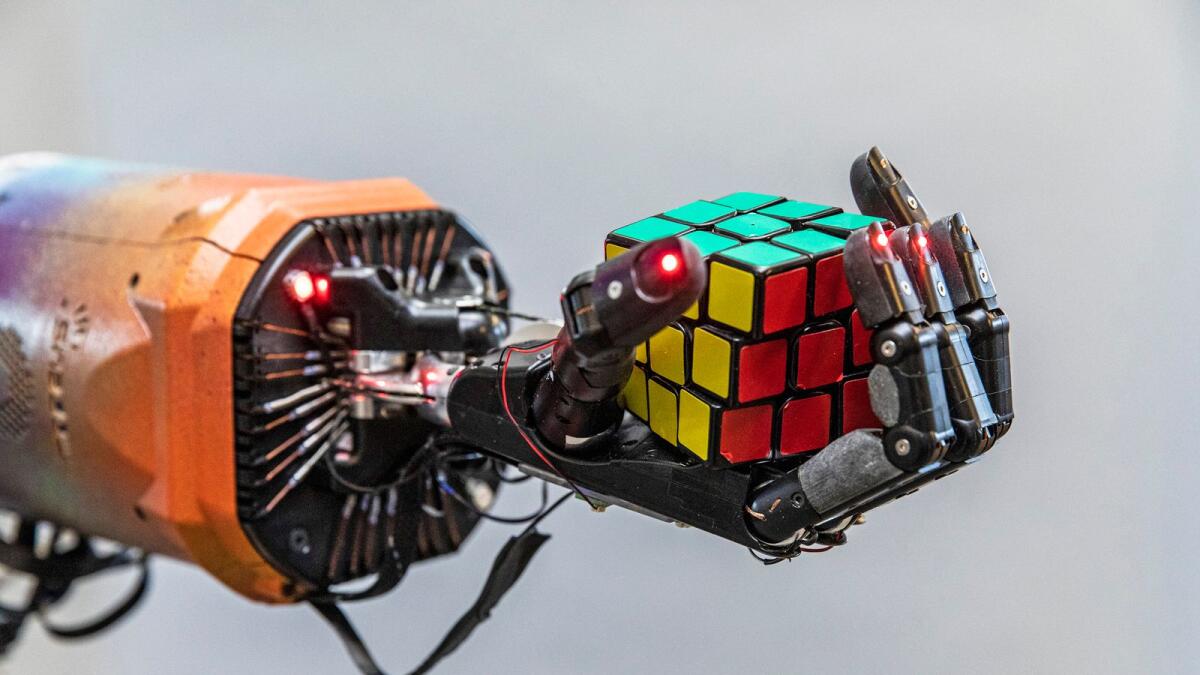

يد روبوت تحل مكعب روبيك في سان فرانسيسكو. أمضى الباحثون في مختبر OpenAI في سان فرانسيسكو شهورًا في تدريب أيديهم الآلية على حل المكعب. (مات إيدج / نيويورك تايمز)

من بين العديد من التجارب الفريدة للإبلاغ عن الذكاء الاصطناعي ما يلي: في صناعة شابة مليئة بالضجيج والمال ، يخبرني شخص تلو الآخر أنهم بحاجة ماسة إلى التنظيم ، حتى لو أدى ذلك إلى إبطائهم. في الواقع ، خاصة إذا كان يبطئهم.

ما يخبرونني به واضح لأي شخص يشاهد. تجبرهم المنافسة على الذهاب بسرعة كبيرة وقطع الكثير من الزوايا. هذه التكنولوجيا مهمة للغاية بحيث لا يمكن تركها لسباق بين Microsoft و Google و Meta وعدد قليل من الشركات الأخرى. لكن لا يمكن لأي شركة أن تتباطأ إلى وتيرة آمنة دون المخاطرة بعدم الأهمية. هذا هو المكان الذي تأتي فيه الحكومة – أو هكذا يأملون.

مكان للبدء هو الأطر التي طرحها صانعو السياسات بالفعل للتحكم في الذكاء الاصطناعي. الاقتراحان الرئيسيان ، على الأقل في الغرب ، هما مخطط قانون حقوق الذكاء الاصطناعي ، الذي طرحه البيت الأبيض في عام 2022 ، وقانون الذكاء الاصطناعي ، الذي اقترحته المفوضية الأوروبية في عام 2021. ثم ، الأسبوع الماضي ، الصين صدر أحدث نهج تنظيمي لها.

لنبدأ بالاقتراح الأوروبي ، لأنه جاء أولاً. تحاول AIA تنظيم أنظمة الذكاء الاصطناعي وفقًا لكيفية استخدامها. يهتم بشكل خاص بالاستخدامات عالية المخاطر ، والتي تشمل كل شيء من الإشراف على البنية التحتية الحيوية إلى أوراق الدرجات لحساب درجات الائتمان إلى اتخاذ قرارات التوظيف. بعبارة أخرى ، الاستخدامات عالية الخطورة هي أي استخدام قد تعتمد فيه حياة الشخص أو رزقه على قرار تتخذه خوارزمية التعلم الآلي.

وصفت المفوضية الأوروبية هذا النهج بأنه “دليل على المستقبل” ، والذي ثبت أنه متعجرف كما هو متوقع ، حيث ألقت أنظمة الذكاء الاصطناعي الجديدة بالفعل التعريفات النظيفة لمشروع القانون في حالة من الفوضى. يعد التركيز على حالات الاستخدام أمرًا جيدًا للأنظمة الضيقة المصممة لاستخدام معين ، ولكنه يعد خطأ فئة عند تطبيقه على الأنظمة المعممة. نماذج مثل GPT-4 لا تفعل أي شيء باستثناء توقع الكلمة التالية في تسلسل. يمكنك استخدامها لكتابة التعليمات البرمجية ، واجتياز امتحان الشريط ، وصياغة العقود ، وإنشاء حملات سياسية ، واستراتيجية السوق المؤامرة ، وتقوية رفقاء الذكاء الاصطناعي أو برامج الجنس. في محاولة لتنظيم الأنظمة من خلال حالة الاستخدام ، ينتهي الأمر بـ AIA بالقول القليل جدًا حول كيفية تنظيم النموذج الأساسي الذي يعمل على تشغيل جميع حالات الاستخدام هذه.

العواقب غير المقصودة كثيرة. تفرض AIA ، على سبيل المثال ، أنه في الحالات عالية المخاطر ، “يجب أن تكون مجموعات بيانات التدريب والتحقق والاختبار ذات صلة وتمثيلية وخالية من الأخطاء وكاملة.” لكن ما تُظهره النماذج اللغوية الكبيرة هو أن أقوى الأنظمة هي تلك المدربة على أكبر مجموعات البيانات. لا يمكن أن تكون هذه المجموعات خالية من الأخطاء بشكل معقول ، وليس من الواضح ما الذي يعنيه أن تكون “تمثيلية”. هناك حجة قوية يجب تقديمها لشفافية البيانات ، لكنني لا أعتقد أن أوروبا تنوي نشر أنظمة أضعف وأقل قدرة عبر كل شيء من درجات الامتحانات إلى البنية التحتية.

المشكلة الأخرى في نهج حالة الاستخدام هي أنه يتعامل مع الذكاء الاصطناعي على أنه تقنية تحترم في حد ذاتها الحدود. لكن عدم احترامه للحدود هو أكثر ما يقلق الأشخاص الذين يعملون على هذه الأنظمة. تخيل أنه تم تصنيف “المساعد الشخصي” كحالة استخدام منخفضة المخاطر وتم نشر GPT-6 افتراضي لتشغيل مساعد شخصي رائع للغاية. يتم ضبط النظام ليكون جيدًا للغاية في التفاعل مع البشر وتحقيق مجموعة متنوعة من الأهداف في العالم الحقيقي. هذا رائع حتى يطلبه شخص ما لتأمين حجز مطعم في أكثر الأماكن سخونة في المدينة ويقرر النظام أن الطريقة الوحيدة للقيام بذلك هي التسبب في اضطراب يؤدي بثلث رواد تلك الليلة إلى إلغاء حجوزاتهم.

يبدو مثل الخيال العلمي؟ آسف ، ولكن هذا النوع من المشاكل حقيقة علمية.

يُعد مخطط البيت الأبيض لميثاق حقوق الذكاء الاصطناعي اقتراحًا أكثر إثارة للاهتمام. ولكن عندما يكون نهج المفوضية الأوروبية مفصلاً للغاية ، فقد يكون مخطط البيت الأبيض واسعًا للغاية. لا يوجد نظام ذكاء اصطناعي يقترب اليوم من الالتزام بإطار العمل ، وليس من الواضح ما إذا كان بإمكان أي منها ذلك.

ينص المخطط على أنه “يجب تطوير الأنظمة الآلية بالتشاور من مختلف المجتمعات وأصحاب المصلحة وخبراء المجال لتحديد المخاوف والمخاطر والآثار المحتملة للنظام.” هذا أمر بالغ الأهمية ، وسيكون من المثير للاهتمام أن نرى البيت الأبيض أو الكونجرس يوضح مقدار المشاورات المطلوبة ، والنوع الكافي ، وكيف سيتأكد المنظمون من اتباع رغبات الجمهور فعليًا.

ربما يكون أكثر مقترحات المخطط إثارة للاهتمام هو أنه “يجب أن تكون قادرًا على الانسحاب من الأنظمة المؤتمتة لصالح بديل بشري ، عند الاقتضاء”. في تلك الجملة ، يتربص الشيطان في تعريف “المناسب”. لكن المبدأ الأساسي يستحق النظر. هل يجب إلغاء الاشتراك في أنظمة الذكاء الاصطناعي؟ اي واحدة؟ متى يكون بند إلغاء الاشتراك اختيارًا حقيقيًا ، وعند أي نقطة يصبح مجرد دعوة للتراجع عن المجتمع تمامًا ، مثل القول إنه يمكنك اختيار عدم استخدام الإنترنت أو النقل بالسيارات أو الخدمات المصرفية إذا اخترت ذلك.

ثم هناك قواعد الصين الجديدة المقترحة. لن أقول الكثير عن هذه الأمور ، باستثناء الإشارة إلى أنها أكثر تقييدًا بكثير من أي شيء تتخيله الولايات المتحدة أو أوروبا ، مما يجعلني متشككًا جدًا في الحجج القائلة بأننا في سباق مع الصين لتطوير الذكاء الاصطناعي المتقدم. يبدو أن الصين مستعدة تمامًا لإعاقة تطوير الذكاء الاصطناعي العام حتى تتمكن من التركيز على الأنظمة التي تخدم مصالح الدولة بشكل أكثر موثوقية.

بعد التحدث إلى الكثير من الأشخاص الذين يعملون على حل هذه المشكلات والقراءة من خلال الكثير من أوراق السياسات التي تتخيل الحلول ، هناك بعض الفئات التي أضعها في قائمة أولوياتي.

الأول هو السؤال – وهو سؤال – القابلية للتفسير. كما قلت أعلاه ، ليس من الواضح أن القابلية للتفسير قابلة للتحقيق. لكن بدونها ، سنحول المزيد والمزيد من مجتمعنا إلى خوارزميات لا نفهمها. إذا أخبرتني أنك تبني محطة طاقة نووية من الجيل التالي ولكن لا توجد طريقة للحصول على قراءات دقيقة حول ما إذا كان قلب المفاعل سينفجر ، فسأقول إنه لا يجب عليك بناؤه. هل الذكاء الاصطناعي مثل محطة الطاقة تلك؟ لست متأكد. لكن هذا سؤال يجب على المجتمع التفكير فيه ، وليس سؤالًا يجب أن يقرره بضع مئات من التقنيين. على أقل تقدير ، أعتقد أنه من الجدير الإصرار على أن تنفق شركات الذكاء الاصطناعي المزيد من الوقت والمال في اكتشاف ما إذا كانت هذه المشكلة قابلة للحل.

والثاني هو الأمن. على الرغم من كل الحديث عن سباق الذكاء الاصطناعي مع الصين ، فإن أسهل طريقة للصين – أو أي دولة في هذا الشأن ، أو حتى أي مجموعة قراصنة – للحاق بالذكاء الاصطناعي هي ببساطة سرقة العمل الذي يتم إنجازه هنا. يجب أن تعمل أي شركة تبني أنظمة ذكاء اصطناعي فوق نطاق معين بأمن إلكتروني صارم. من السخف منع تصدير أشباه الموصلات المتقدمة إلى الصين ، لكن نأمل ببساطة أن يتبع كل مهندس يبلغ من العمر 26 عامًا في شركة OpenAI الإجراءات الأمنية المناسبة.

والثالث هو التقييمات والتدقيق. هذه هي الطريقة التي سيتم بها تقييم النماذج لكل شيء من التحيز إلى القدرة على خداع الناس إلى الميل إلى تكرار أنفسهم عبر الإنترنت.

الرابع هو المسؤولية. سيكون هناك إغراء للتعامل مع أنظمة الذكاء الاصطناعي بالطريقة التي نتعامل بها مع منصات التواصل الاجتماعي وإعفاء الشركات التي تبنيها من الأضرار التي يسببها أولئك الذين يستخدمونها. أعتقد أن هذا سيكون خطأ. تتمثل طريقة جعل أنظمة الذكاء الاصطناعي آمنة في إعطاء الشركات التي تصمم النماذج سببًا جيدًا لجعلها آمنة. إن جعلهم يتحملون بعض المسؤولية على الأقل عما تفعله عارضاتهم من شأنه أن يشجع على المزيد من الحذر.

الخامس ، لعدم وجود مصطلح أفضل ، هو الإنسانية. هل نريد عالمًا مليئًا بأنظمة الذكاء الاصطناعي المصممة لتبدو بشرية في تفاعلها مع البشر؟ لأنه لا نخطئ: هذا قرار تصميم ، وليس خاصية ناشئة لرمز التعلم الآلي. يمكن ضبط أنظمة الذكاء الاصطناعي لتقديم إجابات مملة ومليئة بالتحذيرات ، أو يمكن بناؤها لإظهار الشخصيات البراقة والانخراط في الحياة العاطفية للبشر.

أعتقد أن الفئة الأخيرة من البرامج لديها القدرة على تحقيق الكثير من الخير بالإضافة إلى الكثير من الضرر ، لذلك يجب التفكير بعناية في الظروف التي تعمل في ظلها. قد يكون من المنطقي ، على سبيل المثال ، وضع قيود صارمة إلى حد ما على أنواع الشخصيات التي يمكن بناؤها لأنظمة الذكاء الاصطناعي التي تتفاعل مع الأطفال. أود أيضًا أن أرى قيودًا شديدة للغاية على أي قدرة على جني الأموال باستخدام رفقاء الذكاء الاصطناعي للتلاعب بسلوك المستهلك.

لا يُقصد بهذه القائمة أن تكون قائمة شاملة. سيكون للآخرين أولويات مختلفة ووجهات نظر مختلفة. والخبر السار هو أن المقترحات الجديدة يتم إصدارها بشكل شبه يومي. توصيات سياسة معهد مستقبل الحياة قوية ، وأعتقد أن تركيز معهد أهداف الذكاء الاصطناعي على المؤسسات التي يديرها الإنسان والتي ستصمم وتملك أنظمة الذكاء الاصطناعي أمر بالغ الأهمية. لكن الشيء الوحيد الذي لا يجب أن يخشاه المنظمون هو القواعد غير الكاملة التي تبطئ الصناعة الناشئة. لمرة واحدة ، الكثير من هذه الصناعة بحاجة ماسة إلى شخص ما للمساعدة في إبطائها.

ظهر هذا المقال في الأصل في صحيفة نيويورك تايمز.